Google Bot Crawler क्या है? AI Bots Crawler और अन्य वेब क्रॉलर्स के बीच मुख्य अंतर

“क्या आप जानते हैं कि इंटरनेट पर अरबों वेब पेज हैं? लेकिन जब आप गूगल पर कुछ सर्च करते हैं, तो आपको मात्र कुछ सेकंड में ही आपके सवाल का जवाब मिल जाता है। आखिर ऐसा कैसे होता है? इसका राज है Google Bot Crawler नाम का एक विशेष कंप्यूटर प्रोग्राम। अगर आपके पास अपनी वेबसाइट या ब्लॉग है, तो आपने “Google Bot” का नाम जरूर सुना होगा। यह एक ऐसी Technological process है जो Google सर्च इंजन को हमारे द्वारा खोजी गई जानकारी को तेजी से और सटीकता से उपलब्ध कराने में मदद करती है।

इस ब्लॉग में, हम आपको आसान भाषा में Google Bot के बारे में विस्तार से बताएंगे—Google Bot क्या है, Google Bot Crawler कैसे काम करता है, और आपकी वेबसाइट के SEO में इसकी भूमिका क्यों महत्वपूर्ण है।

इस ब्लॉग में हम समझेंगे कि Google Bot कैसे आपके पेजेस को इंडेक्स करता है, यह कितनी बार आपकी वेबसाइट को क्रॉल करता है, और इसके पीछे का पूरा Technical Framework क्या है। साथ ही, हम आपको बताएंगे कि आप अपनी वेबसाइट को Google Bot के लिए कैसे अनुकूल बना सकते हैं ताकि आपका कंटेंट सर्च रिजल्ट्स में बेहतर रैंक कर सके।

ये भी पढ़ें :

| AI टूल्स को अपनी साइट का कंटेंट चोरी करने से कैसे रोकें | गूगल मैप्स में Latitude और Longitude का इस्तेमाल कैसे करें |

| Google Chrome में “Help Me Write” फीचर का उपयोग कैसे करें | Google Alerts कैसे बनाएं |

Google Bot Crawler क्या है?

Google Bot Crawler एक ऑटोमेटेड सॉफ़्टवेयर प्रोग्राम है, जिसे खासतौर पर Google ने डिज़ाइन किया है ताकि वह इंटरनेट पर मौजूद वेबसाइट्स को नियमित रूप से विज़िट (क्रॉल) करके उनके कंटेंट को समझ सके और Google के डेटाबेस में सेव कर सके। इसे आमतौर पर वेब क्रॉलर या स्पाइडर भी कहा जाता है।

Google Bot एक प्रकार का वेब क्रॉलर है, जिसे Google ने विशेष रूप से इंटरनेट पर मौजूद वेबसाइट्स को स्कैन और इंडेक्स करने के लिए डिज़ाइन किया है। जब आप Google पर कोई भी सर्च करते हैं, तो Google Bot पहले से स्कैन और इंडेक्स किए गए डेटा का उपयोग करके आपको सबसे Relevant और fresh जानकारी दिखाता है।

Web Crawler, Googlebot और Spider क्या हैं?

Web Crawler, Googlebot और Spider सभी एक जैसे टूल हैं, जिनका उपयोग सर्च इंजन और वेबसाइट्स द्वारा इंटरनेट पर पब्लिकली उपलब्ध वेब पेजों को एक्सप्लोर और इंडेक्स करने के लिए किया जाता है। आइए इन्हें विस्तार से समझते हैं:

Web Crawler

- वेब क्रॉलर एक सॉफ्टवेयर प्रोग्राम या बॉट होता है, जिसे वेबसाइट्स के पेजों को systematically ब्राउज़ करने के लिए डिज़ाइन किया गया है।

- इसका मुख्य काम इंटरनेट पर पब्लिक पेजों को ढूंढकर उनकी जानकारी इकट्ठा करना है ताकि सर्च इंजन उन्हें अपनी लिस्ट में जोड़ सकें और यूजर्स को सही जानकारी दिखा सकें।

- क्रॉलर वेबसाइट्स के लिंक को फॉलो करके नई सामग्री ढूंढते हैं और उसे सर्च इंजन के इंडेक्स में जोड़ते हैं।

Googlebot

- Googlebot, Google का विशेष Web Crawler है, जिसे Google द्वारा इंटरनेट की पब्लिक वेबसाइट्स को इंडेक्स और अपडेट करने के लिए बनाया गया है।

- यह दो प्रकार का होता है: Googlebot Desktop (डेस्कटॉप वर्शन के लिए) और Googlebot Mobile (मोबाइल वर्शन के लिए), ताकि दोनों ही प्रकार की वेबसाइट्स को अच्छी तरह समझा जा सके।

- Googlebot वेबसाइट के कंटेंट को एनालाइज करके उसे Google के इंडेक्स में जोड़ता है और यह सुनिश्चित करता है कि वह कंटेंट सर्च रिजल्ट्स में दिखाई दे सके।

Spider

- स्पाइडर एक और नाम है, जो सामान्यतया वेब क्रॉलर के लिए ही उपयोग किया जाता है।

- सर्च इंजन के क्रॉलर को स्पाइडर इसलिए कहा जाता है क्योंकि यह स्पाइडर की तरह वेब (इंटरनेट) पर विभिन्न पेजों के लिंक के जरिए चलता है और नई जानकारी का पता लगाता है।

- Spider अन्य सर्च इंजन के लिए भी काम करता है, जैसे Bing का Bingbot और Yahoo का Slurp।

Google Bot Crawler, AI Crawler Bot और अन्य वेब क्रॉलर्स की जानकारी

वेब क्रॉलिंग वह प्रक्रिया है जिसके द्वारा बॉट्स या क्रॉलर्स इंटरनेट पर विभिन्न वेबसाइट्स से डेटा इकट्ठा करते हैं। ये क्रॉलर्स वेबसाइटों की content, structure और लिंक को स्कैन करते हैं ताकि जानकारी को इंडेक्स किया जा सके या विश्लेषण किया जा सके। Google Bot, AI Crawler Bot और अन्य वेब क्रॉलर्स के काम करने का तरीका, उद्देश्य, और तकनीकी क्षमताएं अलग-अलग होती हैं। आइए इन बॉट्स के बारे में विस्तार से जानें:

1. Google Bot Crawler

Googlebot वह बॉट है जो Google द्वारा इस्तेमाल किया जाता है वेबसाइट्स को क्रॉल करने के लिए, ताकि वे Google के सर्च इंजन में इंडेक्स हो सकें। इसका उद्देश्य वेबसाइट की जानकारी को इकट्ठा करना है, जिससे सर्च इंजन में पेज को उपयुक्त सर्च क्वेरियों के लिए रैंक किया जा सके।

Googlebot का मुख्य उद्देश्य वेबसाइटों को इंडेक्स करना और उन्हें Google सर्च रिजल्ट्स में दिखाना है।

Googlebot वेबसाइट के पेज को क्रॉल करता है और उसकी सामग्री (जैसे कि टेक्स्ट, लिंक, मेटा टैग्स) का विश्लेषण करता है।

Googlebot वेबसाइट की robots.txt फाइल का पालन करता है, जो यह निर्देश देती है कि कौन से पेज क्रॉल किए जा सकते हैं और कौन से नहीं।

उदाहरण: जब Googlebot किसी वेबसाइट को क्रॉल करता है, तो यह नए आर्टिकल्स, अपडेट्स, और पेजों को तेजी से इंडेक्स करता है।

2. AI Crawler Bot

AI Crawler Bots वह बॉट्स होते हैं जो सामान्य क्रॉलिंग के अलावा, डेटा का गहराई से विश्लेषण भी करते हैं। इनमें आर्टिफिशियल इंटेलिजेंस (AI) की क्षमताएं होती हैं, जो इन्हें केवल डेटा इकट्ठा करने से कहीं ज्यादा काम करने में सक्षम बनाती हैं। ये बॉट्स मशीन लर्निंग, नेचुरल लैंग्वेज प्रोसेसिंग (NLP), और अन्य तकनीकों का इस्तेमाल करते हैं।

AI क्रॉलर का उद्देश्य डेटा का संकलन और उसका विश्लेषण करना है ताकि उपयोगकर्ताओं के लिए उन्नत सेवाएं या टूल्स तैयार किए जा सकें, जैसे कि भावना विश्लेषण (Sentiment Analysis), ट्रेंडिंग टॉपिक्स की पहचान, आदि।

AI बॉट्स डेटा को इकट्ठा करने के बाद, उसे मशीन लर्निंग एल्गोरिदम और NLP का उपयोग करके विश्लेषित करते हैं। यह बॉट्स टेक्स्ट, इमेज और वीडियो डेटा का गहराई से विश्लेषण करने में सक्षम होते हैं।

AI बॉट्स आमतौर पर robots.txt का पालन करते हैं, लेकिन इनका उद्देश्य संवेदनशील डेटा तक पहुंचने के लिए विशेष अनुमति प्राप्त करना हो सकता है।

उदाहरण: AI क्रॉलर सोशल मीडिया डेटा का विश्लेषण कर सकता है और यह पहचान सकता है कि लोगों का किसी प्रोडक्ट या सेवा के प्रति क्या रुख है (सकारात्मक या नकारात्मक)।

3. अन्य वेब क्रॉलर्स

अन्य वेब क्रॉलर्स वे बॉट्स होते हैं जो विशिष्ट कार्यों के लिए डिज़ाइन किए जाते हैं। इनका उद्देश्य डेटा माइनिंग, मूल्य तुलना, या वेबसाइट पर किसी विशिष्ट सामग्री को ट्रैक करना हो सकता है। ये बॉट्स बड़े पैमाने पर डेटा इकट्ठा करने के लिए बनाए जाते हैं और विशेष रूप से एक प्रकार के डेटा को खोजने पर ध्यान केंद्रित करते हैं।

इनका उद्देश्य खास प्रकार की जानकारी इकट्ठा करना है, जैसे प्राइस कम्पेरिजन, समाचार ट्रैकिंग, और स्पैम डिटेक्शन।

ये बॉट्स वेबसाइट पर जाकर सिर्फ उन डेटा प्वाइंट्स को इकट्ठा करते हैं जो उनके निर्धारित उद्देश्य से मेल खाते हैं।

ये बॉट्स कुछ वेबसाइट्स की robots.txt का पालन करते हैं, लेकिन कभी-कभी अनधिकृत क्रॉलर्स भी हो सकते हैं जो इन नियमों को नजरअंदाज करते हैं।

उदाहरण: एक प्राइस कम्पेरिजन बॉट विभिन्न ई-कॉमर्स साइट्स से प्रोडक्ट्स की कीमतों को इकट्ठा करता है ताकि वह उपयोगकर्ताओं को विभिन्न वेबसाइट्स की कीमतों की तुलना करने में मदद कर सके।

मुख्य अंतर

| विधि | Google Bot Crawler | AI Crawler Bot |

|---|---|---|

| मुख्य उद्देश्य | वेबसाइट इंडेक्सिंग | डेटा का संकलन और विश्लेषण (Sentiment analysis आदि) |

| विश्लेषण की क्षमता | टेक्स्ट डेटा और लिंक का विश्लेषण | मशीन लर्निंग और NLP का उपयोग, इमेज/वीडियो विश्लेषण |

| कंप्लायंस | robots.txt का पालन करता है | robots.txt का पालन करता है (कभी-कभी अनुमति के साथ) |

| प्रमुख उदाहरण | Google सर्च इंडेक्सिंग | सोशल मीडिया विश्लेषण, भावनात्मक विश्लेषण |

हर क्रॉलर का अपना विशिष्ट उद्देश्य और कार्यप्रणाली है। Google Bot क्रॉलर सर्च इंजन रैंकिंग के लिए उपयोगी है, AI Crawler Bot डेटा का गहराई से विश्लेषण करता है, और अन्य वेब क्रॉलर्स खास कार्यों जैसे मूल्य तुलना और डेटा माइनिंग के लिए डिज़ाइन किए जाते हैं। इनका कार्य और क्षमता इस पर निर्भर करता है कि उनका उपयोग किस प्रकार के डेटा और विश्लेषण के लिए किया जा रहा है।

गूगल बॉट क्रॉलर कैसे काम करता है?

गूगल बॉट क्रॉलर (Googlebot) गूगल सर्च इंजन का एक महत्वपूर्ण हिस्सा है, जो वेबसाइटों के पेजों को व्यवस्थित तरीके से विज़िट करता है और उनकी जानकारी एकत्र करके गूगल के सर्च इंडेक्स में जोड़ता है। जब यूजर्स कोई खोज करते हैं, तो गूगल इसी इंडेक्स से परिणाम प्रस्तुत करता है। गूगल बॉट की कार्यप्रणाली को तीन मुख्य चरणों में विभाजित किया जा सकता है: क्रॉलिंग, इंडेक्सिंग, और रैंकिंग।

1. क्रॉलिंग (Crawling)

क्रॉलिंग का कार्य गूगल बॉट द्वारा वेबसाइटों के पृष्ठों को खोजने और उनकी जानकारी को एकत्र करने का होता है।

लिंक का अनुसरण (Link Following): Googlebot एक पेज से दूसरे पेज तक पहुँचने के लिए HREF और SRC जैसे link structures को फॉलो करता है। अब यह जावास्क्रिप्ट लिंक को भी क्रॉल कर सकता है। Googlebot मल्टी-थ्रेडिंग का उपयोग करता है जिससे यह एक साथ कई लिंक से जुड़ सकता है।

HTTP अनुरोध (HTTP Request): जब Googlebot किसी नए पेज पर जाता है, तो वह सर्वर से HTTP Requests भेजता है। इसके द्वारा वेबसाइट सर्वर को पता चलता है कि यह “वेबबॉट” के रूप में आया है। वेबमास्टर अपनी लॉग फ़ाइलों के माध्यम से देख सकते हैं कि कौन सा बॉट उनकी साइट को क्रॉल कर रहा है।

आवृत्ति (Crawl Frequency): Googlebot के वेबसाइट पर आने की फ्रीक्वेंसी उस पेज के लिंक और पेजरैंक पर निर्भर करती है। अधिक लिंक और बेहतर पेजरैंक वाले पेजेज को अधिक बार क्रॉल किया जाता है।

2. इंडेक्सिंग (Indexing)

क्रॉलिंग के बाद, Googlebot Website pages के कंटेंट को समझता है और उसे गूगल के डेटाबेस में जोड़ता है। इस प्रक्रिया को इंडेक्सिंग कहा जाता है, जिसमें गूगल यह तय करता है कि किसी पेज का कंटेंट को किस प्रकार इंडेक्स में रखा जाए, ताकि सर्च इंजन सही खोज परिणाम प्रदर्शित कर सके।

3. रैंकिंग (Ranking)

जब कोई उपयोगकर्ता गूगल पर खोज करता है, तो गूगल का एल्गोरिदम pages को रैंक करता है और सबसे Relevant results को पहले दिखाता है। यह रैंकिंगQuality, Linking, Content, और User Experience जैसे कई मानकों पर निर्भर करती है।

अन्य महत्वपूर्ण बातें

- कैशिंग: Googlebot साइट के कैश का उपयोग करता है ताकि बार-बार विज़िट करने की आवश्यकता न हो। इससे गूगल बॉट का क्रॉलिंग कोटा भी बचता है और वेबसाइट की गति में सुधार होता है।

- POST मेथड: Googlebot केवल GET मेथड के पृष्ठों को ही कैश करता है, जबकि POST मेथड का उपयोग करने वाले पृष्ठों को क्रॉल नहीं किया जाता है।

गूगल बॉट कैसे तय करता है कि कौन से पेज क्रॉल करें?

गूगल बॉट का मुख्य उद्देश्य वेबसाइट के सभी Important pages को क्रॉल कर उन्हें गूगल के इंडेक्स में शामिल करना है, ताकि वे सर्च परिणामों में दिखाई दें। गूगल बॉट यह तय करने के लिए कई कारकों का उपयोग करता है कि कौन से Pages को क्रॉल करना है। आइए इन मुख्य फैक्टर्स को समझते हैं:

पेज का महत्व (Page Importance)– यदि किसी पेज को बहुत सारे External और internal links मिलते हैं, तो उसे अधिक महत्वपूर्ण माना जाता है।

अगर किसी ब्लॉग पोस्ट को कई अन्य वेबसाइटों से लिंक मिल रहे हैं, तो वह पेज गूगल बॉट द्वारा अधिक बार क्रॉल किया जाएगा।

सामग्री की फ्रेशनेस (Freshness of Content)– गूगल बॉट नए और अपडेट किए गए पेजेज को अधिक बार क्रॉल करता है ताकि गूगल पर फ्रेश जानकारी दिख सके।

समाचार वेबसाइटें या ब्लॉग, जिनमें नियमित रूप से नई कंटेंट जोड़ी जाती है, अधिक बार क्रॉल होते हैं।

क्रॉल बजट (Crawl Budget)– गूगल के पास हर वेबसाइट के लिए सीमित क्रॉलिंग संसाधन होते हैं, जिसे ‘क्रॉल बजट’ कहते हैं। इस बजट के तहत गूगल बॉट प्राथमिकता के आधार पर पृष्ठों को क्रॉल करता है।

बड़ी वेबसाइटों में कई पेज हो सकते हैं, लेकिन गूगल बॉट उन पेजेज को प्राथमिकता देता है जिनमें महत्वपूर्ण और नई जानकारी होती है।

robots.txt और नोइंडेक्स टैग (robots.txt and Noindex Tag)– वेबसाइट के robots.txt फ़ाइल और noindex टैग यह तय करते हैं कि कौन से पेज क्रॉल या इंडेक्स नहीं होने चाहिए।

अगर किसी वेब पेज में संवेदनशील जानकारी है, तो उसे robots.txt में क्रॉल से रोक सकते हैं, ताकि वह गूगल के इंडेक्स में न आए।

इंटरनल लिंक और साइटमैप (Internal Links and Sitemap)– इंटरनल लिंक और साइटमैप से गूगल बॉट को वेबसाइट की स्ट्रक्चर समझने और वेब पेजेज तक पहुँचने में आसानी होती है।

यदि आपकी वेबसाइट का Main category page internal links और साइटमैप में शामिल है, तो गूगल बॉट उसे प्राथमिकता से क्रॉल करेगा।

पेज की लोडिंग स्पीड (Page Loading Speed)– यदि किसी वेबसाइट के पेज धीमी गति से लोड होते हैं, तो गूगल बॉट उसे कम क्रॉल करेगा, जिससे उस पेज की सर्च विजिबिलिटी पर असर पड़ सकता है।

गूगल बॉट तेजी से लोड होने वाले वेब पेजेज को प्राथमिकता देता है ताकि यूजर्स का अनुभव बेहतर रहे।

Googlebot के प्रकार

Googlebot, जो कि Google का वेब क्रॉलर है, कई प्रकार के बॉट्स का समूह है, जो अलग-अलग कार्यों के लिए जिम्मेदार होते हैं। Googlebot के विभिन्न प्रकार वेबसाइटों को क्रॉल करने, इंडेक्स करने, और रैंकिंग को बेहतर बनाने के लिए काम करते हैं। इन बॉट्स को समझना SEO (Search Engine Optimization) के लिए महत्वपूर्ण है क्योंकि ये बॉट्स यह तय करते हैं कि आपकी वेबसाइट का डेटा किस प्रकार Google के सर्च रिजल्ट्स में दिखेगा।

Googlebot दो प्रकार के वेब क्रॉलर्स का सामान्य नाम है जो Google Search द्वारा उपयोग किए जाते हैं:

- Googlebot Smartphone: यह एक मोबाइल क्रॉलर है जो मोबाइल डिवाइस पर एक उपयोगकर्ता का अनुकरण करता है।

- Googlebot Desktop: यह एक डेस्कटॉप क्रॉलर है जो डेस्कटॉप उपयोगकर्ता का अनुकरण करता है।

आप HTTP User-Agent request हेडर में देखकर Googlebot के Subtypes की पहचान कर सकते हैं। हालांकि, दोनों क्रॉलर प्रकार एक ही उत्पाद टोकन (यूज़र एजेंट टोकन) का पालन करते हैं जो robots.txt में होता है, और इसलिए आप robots.txt का उपयोग करके विशेष रूप से Googlebot Smartphone या Googlebot Desktop को टारगेट नहीं कर सकते।

अधिकांश साइटों के लिए, Google Search मुख्य रूप से मोबाइल वर्शन के कंटेंट को इंडेक्स करता है। इस प्रकार, अधिकांश Googlebot crawl requests मोबाइल क्रॉलर द्वारा किए जाते हैं।

Google के सामान्य क्रॉलर्स की सूची

यहां Google के सामान्य क्रॉलर्स की सूची दी जा रही है:

| क्रॉलर का नाम | HTTP अनुरोध में उपयोगकर्ता-एजेंट | robots.txt में उपयोगकर्ता-एजेंट टोकन | प्रभावित उत्पाद |

|---|---|---|---|

| Googlebot | Googlebot Smartphone: Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) … | Googlebot | Google Search, Google Images, Google Video, Google News, Discover आदि। |

| Googlebot Image | Googlebot-Image/1.0 | Googlebot-Image | Google Images, Discover, Google Video, और Google Search में चित्रों का प्रदर्शन। |

| Googlebot Video | Googlebot-Video/1.0 | Googlebot-Video | वीडियो संबंधित Google Search फीचर्स और अन्य उत्पाद जिनमें वीडियो का उपयोग किया जाता है। |

| Googlebot News | Googlebot-news कोई अलग HTTP अनुरोध यूज़र एजेंट नहीं होता। Googlebot के विभिन्न एजेंट का उपयोग होता है। | Googlebot-News | Google News (Google Search के News टैब और Google News ऐप) पर सभी डेटा। |

| Google StoreBot | Desktop: Mozilla/5.0 (X11; Linux x86_64; Storebot-Google/1.0) | Storebot-Google | Google Shopping (Shopping टैब और Google Shopping)। |

| Google-InspectionTool | Desktop: Mozilla/5.0 (compatible; Google-InspectionTool/1.0;) | Google-InspectionTool | Rich Result Test और URL Inspection (Search Console) जैसे Search Testing Tools। |

| GoogleOther | GoogleOther-Image/1.0 | GoogleOther-Image | यह क्रॉलर किसी विशिष्ट उत्पाद को प्रभावित नहीं करता, इसे आंतरिक शोध और विकास के लिए उपयोग किया जाता है। |

नोट: User-agent strings को स्पूफ किया जा सकता है, इसलिए यह सुनिश्चित करने के लिए कि क्या कोई विज़िटर Googlebot है, आपको सही विधियों का पालन करना चाहिए।

Googlebot (Desktop) यह बॉट मुख्य रूप से Desktop version के pages को क्रॉल करता है। इसका उद्देश्य उन pages को ढूंढना और क्रॉल करना है जो डेस्कटॉप यूजर्स के लिए उपलब्ध होते हैं।

Googlebot-Mobile यह बॉट Mobile Version के pages को क्रॉल करता है। चूंकि Google ने “मोबाइल-फर्स्ट इंडेक्सिंग” को लागू किया है, इस बॉट का कार्य अधिक महत्वपूर्ण हो गया है। अब Google मोबाइल-फ्रेंडली साइटों को प्राथमिकता देता है।

Googlebot-News यह बॉट खासतौर पर समाचार साइटों को क्रॉल करता है और ताजा खबरों को Google News इंडेक्स में शामिल करता है। यह बॉट नियमित रूप से नई और ताजा खबरों को ट्रैक करता है ताकि उपयोगकर्ताओं को नवीनतम समाचार उपलब्ध हो सके।

Googlebot-Image यह बॉट वेबसाइटों पर इमेजेस को क्रॉल करता है। इसका उद्देश्य चित्रों को Google Images सर्च में इंडेक्स करना है ताकि उपयोगकर्ता चित्रों के माध्यम से भी खोज कर सकें।

Googlebot-Video यह बॉट वीडियो कंटेंट को क्रॉल करता है और उसे Google Video सर्च में इंडेक्स करता है।

Googlebot-Ads यह बॉट विशेष रूप से उन pages के विज्ञापनों को क्रॉल करता है जो Google Ads से संबंधित होते हैं। यह बॉट विज्ञापन कंटेंट को इंडेक्स करता है ताकि Google Ads प्लेटफ़ॉर्म को बेहतर तरीके से ऑप्टिमाइज किया जा सके।

ये सभी बॉट्स मिलकर Google को इंटरनेट की विशाल मात्रा में जानकारी को इकट्ठा करने, समझने और यूजर्स को Relevant results प्रदान करने में मदद करते हैं।

Google के special-case crawlers

Google के special-case crawlers ऐसे crawlers होते हैं जो कुछ विशेष Google प्रोडक्ट्स द्वारा उपयोग किए जाते हैं। इन crawlers का क्रॉलिंग प्रक्रिया उस साइट के मालिक से सहमति के आधार पर निर्धारित होती है। उदाहरण के तौर पर, AdsBot का उपयोग विज्ञापन के लिए किया जाता है और यह सामान्य robots.txt नियमों को नजरअंदाज कर सकता है यदि साइट के मालिक ने इसके लिए अनुमति दी हो।

यहाँ पर एक टेबल के रूप में Google Crawlers, उनके User-Agent, Robots.txt सेटिंग्स और प्रभावित उत्पाद दिए गए हैं:

| Crawler | User-Agent in HTTP Requests | Robots.txt | Example Robots.txt Group | Affected Products |

|---|---|---|---|---|

| APIs-Google | APIs-Google (+https://developers.google.com/webmasters/APIs-Google.html) | APIs-Google | user-agent: APIs-Google allow: /archive/1Q84 disallow: /archive/ | Crawling preferences affect push notifications from Google APIs. |

| AdsBot Mobile Web | Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; AdsBot-Google-Mobile; +http://www.google.com/mobile/adsbot.html) | AdsBot-Google-Mobile | user-agent: AdsBot-Google-Mobile allow: /archive/1Q84 disallow: /archive/ | Affects Google Ads’ ability to check web page ad quality. |

| AdsBot | AdsBot-Google (+http://www.google.com/adsbot.html) | AdsBot-Google | user-agent: AdsBot-Google allow: /archive/1Q84 disallow: /archive/ | Affects Google Ads’ ability to check web page ad quality. |

| AdSense | Mediapartners-Google (Desktop agent) (Various mobile device types) (compatible; Mediapartners-Google/2.1; +http://www.google.com/bot.html) | Mediapartners-Google | user-agent: Mediapartners-Google allow: /archive/1Q84 disallow: /archive/ | Affects Google AdSense. Crawls sites to serve relevant ads. |

| Google-Safety | Google-Safety | N/A (Ignores robots.txt) | N/A | Handles abuse-specific crawling (e.g., malware discovery). |

गूगल बॉट क्रॉल रेट (Google Bot Crawl Rate)

Googlebot क्रॉल रेट से तात्पर्य यह है कि Google का बॉट (Googlebot) आपकी वेबसाइट को कितनी बार और कितनी तेजी से स्कैन करता है। जब Googlebot आपकी वेबसाइट पर आता है, तो वह एक-एक पेज को देखता है, उसमें मौजूद जानकारी को अपने रिकॉर्ड में शामिल करता है और उस जानकारी को सर्च रिजल्ट में दिखाने के लिए सेव कर लेता है। ये प्रक्रिया लगातार चलती रहती है, ताकि आपकी वेबसाइट पर कोई नई जानकारी हो तो उसे Google तुरंत ढूंढ सके।

Googlebot की Crawling Frequency और उसे प्रभावित करने वाले मुख्य कारक

वेबसाइट का आकार (Website Size): अगर आपकी वेबसाइट पर बहुत सारे पेज हैं, तो Googlebot को उन सभी पेजों को स्कैन करने के लिए ज्यादा बार आना पड़ सकता है। बड़ी वेबसाइटों का क्रॉल रेट आमतौर पर अधिक होता है क्योंकि Googlebot को उन पर अधिक पेज देखने होते हैं।

पेज रैंक और लिंक संरचना (Page Rank and Link Structure): अगर आपकी वेबसाइट का पेज रैंक ज्यादा है, यानी वह Google के अनुसार महत्वपूर्ण है, तो Googlebot उस पर ज्यादा ध्यान देता है। इसके अलावा, अगर वेबसाइट में अच्छी लिंकिंग संरचना है (अर्थात् सभी पेज एक-दूसरे से अच्छे से जुड़े हुए हैं), तो Googlebot के लिए आपकी वेबसाइट को स्कैन करना आसान हो जाता है।

कंटेंट का अपडेट होना (Content Updates): अगर आप नियमित रूप से अपनी वेबसाइट पर नई कंटेंट जोड़ते हैं या पुरानी कंटेंट को अपडेट करते हैं, तो Googlebot इसे और अधिक बार क्रॉल करेगा ताकि वह नई जानकारी को सर्च इंजन में जोड़ सके।

वेबसाइट की लोडिंग स्पीड (Site Loading Speed): अगर आपकी वेबसाइट जल्दी लोड होती है, तो Googlebot ज्यादा जल्दी पेजों को स्कैन कर सकता है। इससे उसकी Crawling Frequency भी बढ़ सकती है। वहीं, धीमी वेबसाइटों को स्कैन करने में बॉट को ज्यादा समय लगता है, जिससे क्रॉल रेट कम हो सकता है।

तकनीकी SEO सेटिंग्स (Technical SEO Settings): आपकी वेबसाइट की तकनीकी सेटिंग्स जैसे कि robots.txt फाइल, canonical टैग्स, और Google Search Console की सेटिंग्स भी क्रॉल रेट को प्रभावित करती हैं। उदाहरण के लिए, अगर आप अपनी साइट के कुछ हिस्सों को Googlebot से छिपाना चाहते हैं, तो आप robots.txt में उन पेजों को ब्लॉक कर सकते हैं।

सर्वर की क्षमता और क्रॉल बजट (Server Performance and Crawl Budget): Googlebot का एक सीमित क्रॉल बजट होता है, यानी वह एक साइट के कितने पेज एक बार में स्कैन कर सकता है। अगर आपकी वेबसाइट का सर्वर तेज़ है और उसमें ज्यादा रिसोर्सेज हैं, तो Googlebot ज्यादा पेज क्रॉल कर सकता है।

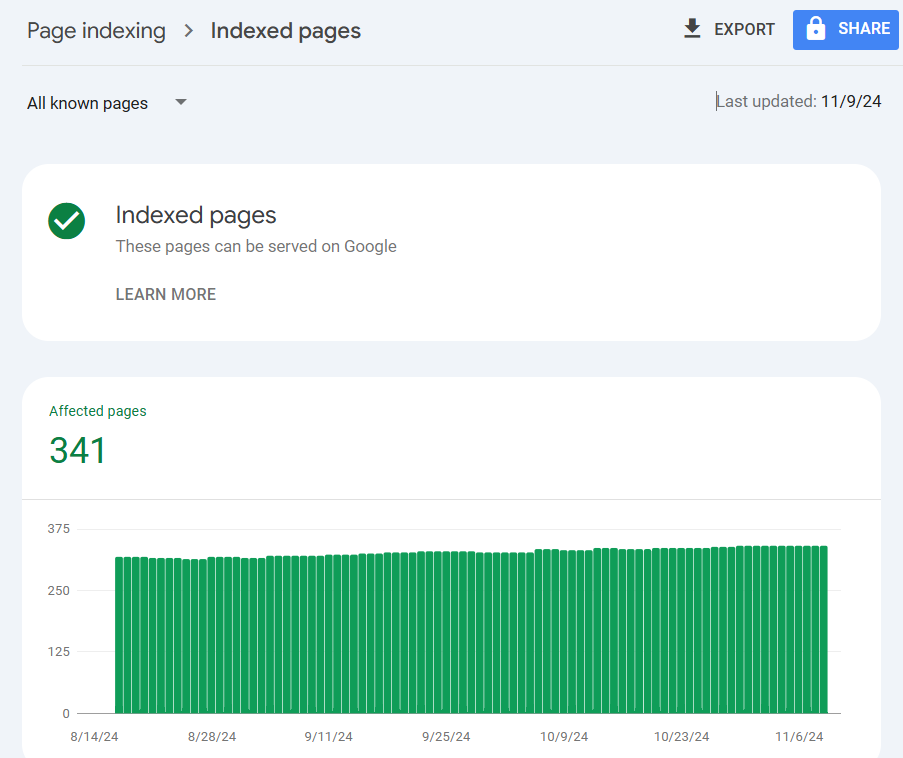

Googlebot कितनी बार आपकी साइट को क्रॉल करता है?

Googlebot कितनी बार किसी साइट को क्रॉल करता है, यह वेबसाइट की ट्रैफिक, सामग्री, और SEO पर निर्भर करता है। आमतौर पर:

- अगर आप नियमित रूप से नई जानकारी डालते हैं, तो Googlebot इसे ज्यादा बार स्कैन करेगा।

- आपकी साइट पर ज्यादा बैकलिंक्स हैं और यह लोकप्रिय है, तो Googlebot इसे ज्यादा बार देखेगा।

- तेज़ सर्वर Googlebot को अधिक बार और जल्दी-जल्दी क्रॉल करने में मदद करता है।

Googlebot का User-Agent और IP

Googlebot का User-Agent String: Googlebot का User-Agent स्ट्रिंग यह बताता है कि यह एक Googlebot क्रॉलर है जो वेब पेजों को क्रॉल करने के लिए आता है। यह स्ट्रिंग वेबसाइट सर्वर को Googlebot की पहचान करने में मदद करती है।

Googlebot User-Agent String का उदाहरण: Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) इसमें:

Mozilla/5.0: यह सामान्य ब्राउज़र स्ट्रिंग है, जो यह दर्शाता है कि Googlebot वेब ब्राउज़र की तरह काम करता है।

Googlebot/2.1: यह Googlebot के संस्करण को दर्शाता है।

+http://www.google.com/bot.html: यह लिंक Googlebot के बारे में और जानकारी प्रदान करता है।

Googlebot द्वारा उपयोग किए गए IP रेंज: Googlebot विभिन्न IP रेंज का उपयोग करता है जब वह आपकी वेबसाइट को क्रॉल करता है। कुछ सामान्य IP रेंज इस प्रकार हैं:

66.249.64.0 – 66.249.95.255

64.233.160.0 – 64.233.191.255

66.102.0.0 – 66.102.63.255

Googlebot की प्रामाणिकता कैसे वेरीफाई करें:

Googlebot के IP एड्रेस पर रिवर्स DNS लुकअप करें और यह जांचें कि क्या यह “googlebot.com” से संबंधित है।

Googlebot और Robots.txt

Robots.txt एक टेक्स्ट फ़ाइल है जो वेबसाइट के रूट डायरेक्टरी में रखी जाती है। यह Googlebot और अन्य वेब क्रॉलर्स को यह बताती है कि कौन से पेजों को क्रॉल करना है और कौन से नहीं।

Robots.txt में नियम सेट करने के उदाहरण:

सभी क्रॉलर्स को क्रॉल से रोकना: User-agent: * Disallow: / यह नियम सभी क्रॉलर्स को आपकी वेबसाइट के सभी पेजों को क्रॉल करने से रोक देगा।

विशेष क्रॉलर को क्रॉल से रोकना: User-agent: Googlebot Disallow: /private/ यह नियम Googlebot को /private/ पथ को क्रॉल करने से रोकता है, जबकि अन्य क्रॉलर्स को अनुमति रहती है।

Robots.txt सेटअप में सामान्य गलतियाँ

गलत स्थान पर फाइल रखना: Robots.txt फाइल को वेबसाइट के रूट डायरेक्टरी में रखना चाहिए, वरना Googlebot इसे नहीं पहचान पाएगा।

क्रॉलिंग से पूरी वेबसाइट को ब्लॉक करना: यदि आप Disallow: / का उपयोग करते हैं, तो यह आपकी पूरी वेबसाइट को क्रॉल से रोक देगा, जो SEO के लिए हानिकारक हो सकता है।

Disallow और Allow के बीच असमंजस: यदि आपने गलत तरीके से इन निर्देशों का उपयोग किया, तो Googlebot गलत पृष्ठों को क्रॉल कर सकता है।

बहुत अधिक पृष्ठों को क्रॉल से रोकना: यदि आप बहुत अधिक पृष्ठों को क्रॉल से रोकते हैं, तो आपकी वेबसाइट का महत्वपूर्ण कंटेंट Googlebot से इंडेक्स नहीं हो पाएगा, जो SEO को प्रभावित कर सकता है।

Googlebot के crawling behavior को टेस्ट कैसे करें? (Testing the Googlebot Crawler)

Googlebot की क्रॉलिंग प्रक्रिया को ठीक से समझने और जाँचने के लिए, आप यह देख सकते हैं कि Googlebot आपके साइट के पेजों को कैसे क्रॉल करता है। इस प्रक्रिया को “Crawl Testing” कहते हैं। आप निम्नलिखित तरीके से Googlebot का परीक्षण कर सकते हैं:

URL Inspection Tool (Google Search Console): इस टूल के माध्यम से आप यह देख सकते हैं कि Googlebot किसी पेज को किस तरह क्रॉल कर रहा है। आप URL टेस्ट कर सकते हैं और जान सकते हैं कि कोई पेज इंडेक्स हो रहा है या नहीं, और यदि नहीं हो रहा है तो क्यों।

URL Inspection Tool में आपको URL डालने पर यह बताएगा कि Googlebot उस URL को कैसे क्रॉल करता है और क्या उसमें कोई समस्या है।

Fetch as Google: यह टूल आपको Googlebot के दृष्टिकोण से एक पेज को देखने की सुविधा देता है। यह आपको क्रॉल करने के दौरान दिखाए जाने वाले तत्वों और किसी भी क्रॉलिंग या रेंडरिंग मुद्दों को चेक करने में मदद करता है।

Testing Steps:

- Google Search Console में लॉग इन करें।

- “URL Inspection Tool” में URL डालें।

- “Test Live URL” पर क्लिक करें, जिससे Googlebot का वह URL कैसे क्रॉल करता है, आपको दिखेगा।

इन टूल्स की मदद से आप अपनी साइट के क्रॉलिंग व्यवहार की जाँच कर सकते हैं और यह सुनिश्चित कर सकते हैं कि कोई पेज Googlebot द्वारा ठीक से क्रॉल हो रहा है या नहीं।

Googlebot Crawl Rate को कैसे कम करें

Googlebot, Google का वेब क्रॉलर, वेबसाइटों को नियमित रूप से क्रॉल करता है ताकि सर्च इंजन रिजल्ट्स (SERPs) में नई और अपडेटेड जानकारी दिखाई दे सके। हालांकि, कभी-कभी वेबसाइट के सर्वर पर अत्यधिक लोड या अन्य तकनीकी कारणों से, Googlebot का क्रॉल रेट बढ़ सकता है, जिससे वेबसाइट की परफॉर्मेंस पर असर पड़ सकता है। इस स्थिति से निपटने के लिए, आप Googlebot का क्रॉल रेट कम करने का निर्णय ले सकते हैं।

Googlebot Crawl Rate को कम करने से पहले ध्यान रखने योग्य बातें:

- Googlebot की क्रॉल रेट को कम करने से आपके वेबसाइट के पेजों का इंडेक्स होने की गति धीमी हो सकती है।

- वेबसाइट की product availability और अन्य जानकारी का अपडेट SERPs में देरी से दिखेगा।

- पेजों को हटाने में भी अधिक समय लग सकता है और वे लंबे समय तक इंडेक्स में रह सकते हैं।

Googlebot Crawl Rate को कम करने के तरीके

HTTP Error Codes (500, 503, 429) का उपयोग

कभी-कभी, आपको तुरंत क्रॉल रेट को कम करने के लिए अपने सर्वर से कुछ विशेष HTTP Error Codes (500, 503, और 429) रिटर्न करने होते हैं। जब Googlebot इन स्टेटस कोड्स का सामना करता है, तो वह आपकी वेबसाइट का क्रॉल रेट घटा देता है।

- 500 (Internal Server Error), 503 (Service Unavailable), और 429 (Too Many Requests) जैसे कोड्स को सर्वर से भेजने से Googlebot समझता है कि साइट पर लोड अधिक है और यह क्रॉलिंग की गति कम कर देता है।

- यह तरीका एक अस्थायी उपाय है और 1-2 दिन तक उपयोग किया जा सकता है। हालांकि, यदि यह स्थिति लंबे समय तक बनी रहती है, तो Googlebot आपकी साइट को इंडेक्स से हटा सकता है।

Crawl Efficiency को ऑप्टिमाइज़ करें

यदि आपकी साइट पर संरचनात्मक समस्याएं या तकनीकी गलतियाँ हैं, तो Googlebot की क्रॉलिंग अधिक हो सकती है, और साइट पर अधिक लोड आ सकता है। इसे ठीक करने के लिए:

- XML Sitemap का उपयोग करें: अपने सभी महत्वपूर्ण पेजों की सूची को XML Sitemap में शामिल करें ताकि Googlebot आसानी से समझ सके कि कौन से पेजों को क्रॉल करना है।

- Robots.txt फाइल का उपयोग: इस फाइल का उपयोग करके आप Googlebot को कुछ पेजों को क्रॉल करने से रोक सकते हैं।

सर्वर की क्षमता और संसाधनों को बढ़ाएँ

यदि आपकी वेबसाइट पर अधिक ट्रैफिक और क्रॉलिंग हो रही है, तो आप सर्वर की क्षमता को बढ़ाने पर विचार कर सकते हैं। इससे Googlebot के लिए वेबसाइट को क्रॉल करना आसान होगा और आपके सर्वर पर लोड भी कम होगा। बेहतर सर्वर रेस्पॉन्स टाइम और उच्च बैंडविड्थ से Googlebot की क्रॉलिंग अधिक प्रभावी होगी।

Googlebot को अपनी वेबसाइट के लिए ऑप्टिमाइज़ कैसे करें

Googlebot को अपनी वेबसाइट के लिए ऑप्टिमाइज़ करना SEO का महत्वपूर्ण हिस्सा है, ताकि आपकी साइट को बेहतर तरीके से क्रॉल किया जा सके और सर्च इंजन रिजल्ट्स (SERPs) में उसकी रैंकिंग बढ़ सके। यह प्रक्रिया Googlebot को आपकी वेबसाइट को तेजी से और प्रभावी तरीके से समझने और इंडेक्स करने में मदद करती है। यहां कुछ प्रमुख कदम दिए गए हैं जिन्हें आप Googlebot को अपनी वेबसाइट के लिए ऑप्टिमाइज़ करने के लिए उठा सकते हैं:

XML Sitemap का उपयोग करें

XML Sitemap Googlebot को आपकी वेबसाइट के सभी महत्वपूर्ण पेजों को ढूंढने और क्रॉल करने में मदद करता है। इसे Google Search Console में अपलोड करें ताकि Googlebot को यह बताने में मदद मिले कि कौन से पेज क्रॉल करने हैं और कौन से नहीं।

यदि आप वर्डप्रेस उपयोग करते हैं, तो Yoast SEO या Rank Math जैसे प्लगइन्स के जरिए XML Sitemap जनरेट कर सकते हैं। इसे Google Search Console में सबमिट करें।

Robots.txt फाइल का उपयोग करें

Robots.txt फाइल का उपयोग करके आप Googlebot को अपनी वेबसाइट पर क्रॉल करने से कुछ पेजों को रोक सकते हैं। यह फाइल Googlebot को निर्देश देती है कि कौन से पेजों को क्रॉल किया जा सकता है और कौन से नहीं।

सुनिश्चित करें कि आपने Googlebot को महत्वपूर्ण पेजों को क्रॉल करने की अनुमति दी है और अप्रासंगिक पेजों को ब्लॉक किया है। उदाहरण: User-agent: Googlebot Disallow: /private-directory/ Allow: /public-directory/

User Experience और साइट स्पीड में सुधार करें

Googlebot की प्राथमिकता उन साइट्स को है जो तेज़ लोड होती हैं और यूजर्स के लिए अच्छा अनुभव देती हैं। यदि आपकी साइट धीमी लोड होती है या यूजर फ्रेंडली नहीं है, तो Googlebot इसे क्रॉल करने में परेशानी महसूस कर सकता है।

साइट की लोडिंग स्पीड को बढ़ाने के लिए कंप्रेस्ड इमेजेस, JavaScript और CSS को मिनिफाई करें, और एक अच्छा कैशिंग सिस्टम सेट करें। Google PageSpeed Insights का उपयोग करके सुधार के सुझाव प्राप्त करें।

साइट की स्ट्रक्चर को बेहतर बनाएं

Googlebot को आपकी वेबसाइट को आसानी से क्रॉल करने के लिए एक Clear और structured site की आवश्यकता होती है। एक अच्छी साइट संरचना Googlebot को आपकी वेबसाइट के सभी पेजों तक पहुंचने में मदद करती है।

सुनिश्चित करें कि आपकी वेबसाइट में एक स्पष्ट नेविगेशन है, और सभी महत्वपूर्ण पेजों से लिंक किए गए हैं। यदि संभव हो, तो लिंक जूस को अच्छे से वितरित करें ताकि Googlebot सभी पेजों तक आसानी से पहुंच सके।

Mobile-First Indexing का पालन करें

Google अब मोबाइल-फर्स्ट इंडेक्सिंग का पालन करता है, जिसका मतलब है कि Googlebot आपकी वेबसाइट के मोबाइल संस्करण को प्राथमिकता देता है, न कि डेस्कटॉप संस्करण को। यदि आपकी साइट मोबाइल-फ्रेंडली नहीं है, तो यह आपकी रैंकिंग को प्रभावित कर सकता है।

सुनिश्चित करें कि आपकी साइट मोबाइल पर अच्छी तरह से काम करती है। Google का Mobile-Friendly Test टूल का उपयोग करके यह जांचें कि आपकी वेबसाइट मोबाइल यूजर्स के लिए अनुकूल है या नहीं।

Crawl Budget को ऑप्टिमाइज़ करें

Googlebot हर साइट को क्रॉल करने के लिए एक सीमित क्रॉल बजट देता है। यदि आपकी वेबसाइट बहुत बड़ी है या आपकी साइट में ग़लत लिंक या अप्रासंगिक पेज हैं, तो Googlebot को उन्हें क्रॉल करने में ज्यादा समय लग सकता है।

साइट की Irrelevant pages को हटा दें, 404 पेजों को सही करें और पुराने पेजों को अपडेट करें। इससे Googlebot का क्रॉल बजट बेहतर तरीके से उपयोग होगा।

Structured Data (Schema Markup) का उपयोग करें

Structured Data (Schema Markup) का उपयोग Googlebot को आपकी वेबसाइट के कंटेंट को बेहतर तरीके से समझने में मदद करता है। इससे आपकी वेबसाइट के पेजों के बारे में अधिक जानकारी Google को मिलती है, जिससे सर्च रिजल्ट्स में आपकी साइट की visibility बढ़ सकती है।

Schema.org के मार्कअप को अपनी वेबसाइट पर लागू करें, जैसे कि FAQ Schema, Product Schema, Article Schema, आदि। Google Structured Data Testing Tool का उपयोग करके यह सुनिश्चित करें कि आपका मार्कअप सही है।

Canonical URLs का उपयोग करें

यदि आपकी वेबसाइट पर एक ही कंटेंट कई URLs पर उपलब्ध है, तो Googlebot को यह बताने के लिए rel=”canonical” टैग का उपयोग करें कि कौन सा URL प्राथमिक है। इससे Googlebot को डुप्लिकेट कंटेंट से बचने में मदद मिलती है।

प्रत्येक पेज के HTML में rel=”canonical” लिंक टैग को सही URL के साथ जोड़ें।

404 पेज और Broken Links को ठीक करें

Googlebot उन पेजों को क्रॉल करता है जिनके लिंक सही होते हैं। यदि आपकी वेबसाइट पर बहुत सारे 404 (Not Found) पेज हैं, तो Googlebot का समय और क्रॉलिंग बजट खराब हो सकता है।

Broken links को ठीक करें और सभी 404 पेजों को 301 रीडायरेक्ट या सही पेजों पर रीडायरेक्ट करें।

Google Search Console का उपयोग करें

Google Search Console आपको अपनी वेबसाइट पर Googlebot के क्रॉलिंग व्यवहार पर नज़र रखने और सुधार करने के लिए कई टूल्स प्रदान करता है। यह आपको किसी भी क्रॉलिंग समस्या को पहचानने में मदद करता है।

“Crawl Stats” और “Coverage” रिपोर्ट्स का उपयोग करें ताकि आप देख सकें कि Googlebot आपकी वेबसाइट को किस तरह क्रॉल कर रहा है और क्या कोई समस्याएँ हैं।

निष्कर्ष

Googlebot और AI Crawlers को समझने का महत्व: Googlebot और AI Crawlers के क्रॉलिंग व्यवहार को समझना वेबसाइट के SEO के लिए बहुत महत्वपूर्ण है, क्योंकि इससे आपको यह पता चलता है कि ये बॉट्स आपकी साइट के पेजों को कैसे क्रॉल करते हैं और इंडेक्स करते हैं। AI Crawlers इन बॉट्स को और भी ज्यादा स्मार्ट और प्रासंगिक बनाते हैं। इससे आपको अपनी वेबसाइट को Google के साथ-साथ AI Crawlers के लिए भी ऑप्टिमाइज़ करने में मदद मिलती है, ताकि आपके पेजों को अधिक से अधिक सर्च रिजल्ट्स में दिखाया जा सके।

![[2024 Guide] गूगल न्यूज़ में वेबसाइट कैसे जोड़ें? | Add Website To Google News Publisher Center 6 [2024 Guide] गूगल न्यूज़ में वेबसाइट कैसे जोड़ें? | Add Website To Google News Publisher Center](https://nitishverma.com/wp-content/uploads/2021/12/Add-Website-To-Google-News-768x431.jpg)

Achi jankari mili